אתם יכולים להשתמש באותו מודל AI בדיוק — ולקבל תוצאה בינונית או תוצאה מעולה. ההבדל לא במודל, אלא בפרומפט. Prompt Engineering הוא הידע של איך לנסח הוראות ל-AI כך שהוא יבין בדיוק מה אתם רוצים ויספק את התוצאה הטובה ביותר.

זה לא רק "לשאול שאלה טובה" — ב-2026 מדובר בתחום מקצועי עם טכניקות מוכחות, מחקרים אקדמיים ודפוסים שעובדים באופן עקבי.

העקרונות הבסיסיים

לפני שנצלול לטכניקות מתקדמות, שלושה עקרונות שתמיד צריך לזכור:

1. היו ספציפיים

"תכתוב לי טקסט שיווקי" — גרוע. "תכתוב 3 פסקאות שיווקיות לדף נחיתה של אפליקציית ניהול משימות, קהל יעד: פרילנסרים, טון: מקצועי אבל לא פורמלי, בעברית" — הרבה יותר טוב. ככל שאתם מדויקים יותר, ה-AI צריך לנחש פחות.

2. תנו הקשר

ה-AI לא יודע מי אתם, מה הפרויקט שלכם, או מה המטרה. כל פיסת מידע רלוונטית שתספקו — משפרת את התוצאה. זה כולל: מי קהל היעד, מה הפורמט הרצוי, מה ההגבלות.

3. הגדירו את הפלט

אם אתם רוצים JSON — אמרו את זה. אם אתם רוצים רשימה ממוספרת — בקשו. אם אתם רוצים 200 מילים ולא יותר — ציינו. הגדרת פורמט הפלט מצמצמת עמימות ומשפרת עקביות.

טכניקות מתקדמות

Chain of Thought (CoT)

במקום לבקש תשובה ישירה, מבקשים מה-AI לחשוב צעד אחר צעד. המחקר המקורי של Google (Wei et al., 2022) הראה שהטכניקה משפרת דיוק במשימות חשיבה מ-17.7% ל-78.7% במודלים גדולים.

דוגמה רעה: "כמה עולה לחמם דירת 3 חדרים בתל אביב בחורף?"

דוגמה טובה: "חשב צעד אחר צעד: 1) מה שטח ממוצע של דירת 3 חדרים בתל אביב? 2) מה צריכת החימום לשעה למ״ר? 3) כמה שעות חימום ביום בחורף? 4) מה מחיר החשמל לקוט״ש? 5) מהי העלות החודשית?"

Few-Shot Learning

נותנים ל-AI כמה דוגמאות של קלט ופלט רצוי — והוא לומד את הדפוס. זה עובד מצוין כשיש לכם סגנון מסוים או פורמט ייחודי שקשה לתאר במילים.

דוגמה: קלט: "מסעדת השף - סטייק מדיום עם ירקות צלויים" פלט: "🥩 מסעדת השף | סטייק מדיום + ירקות צלויים | ⭐⭐⭐⭐" קלט: "קפה ביאליק - אספרסו כפול ועוגת שוקולד" פלט:

ה-AI יבין את הפורמט ויחזיר תשובה עקבית בלי שתצטרכו להסביר את הכללים.

System Prompts

ב-APIs כמו של Anthropic ו-OpenAI, יש הפרדה בין System Prompt (הוראות מערכת) ל-User Message (ההודעה עצמה). ה-System Prompt מגדיר את "האישיות" וההתנהגות הכללית. לפי Anthropic, System Prompt אפקטיבי כולל: תפקיד, סגנון, מגבלות, ופורמט פלט.

Structured Output

כשעובדים עם API, כדאי לדרוש פלט מובנה — בדרך כלל JSON. זה מבטיח שהתשובה תהיה parseable באופן אוטומטי:

ענה בפורמט JSON בלבד:

{

"summary": "סיכום בשורה אחת",

"key_points": ["נקודה 1", "נקודה 2"],

"sentiment": "positive/negative/neutral",

"confidence": 0.0-1.0

}

Role Prompting

הגדרת תפקיד ל-AI שמתאים למשימה. "אתה מומחה SEO עם 10 שנות ניסיון" — גורם למודל למשוך ידע רלוונטי מאותו תחום. מחקרים הראו ש-Role Prompting משפר ביצועים בעד 15% במשימות דומיין-ספציפיות.

טכניקות ל-2026: מה חדש

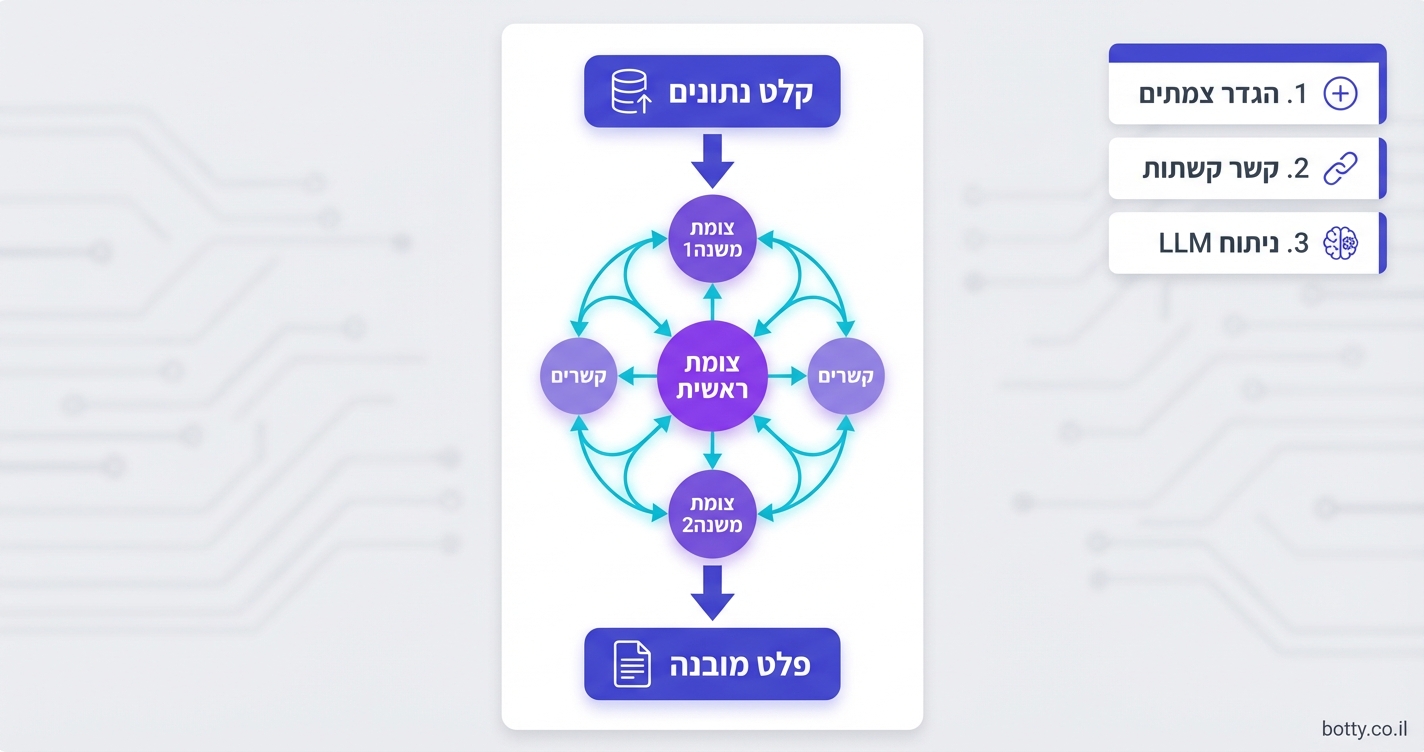

Prompt Chaining

פירוק משימה מורכבת לשרשרת של פרומפטים. הפלט של כל שלב הופך לקלט של השלב הבא. זה הבסיס של Agentic AI — ובפרט של כלים כמו Claude Code שמפרקים משימות לשלבים אוטומטית.

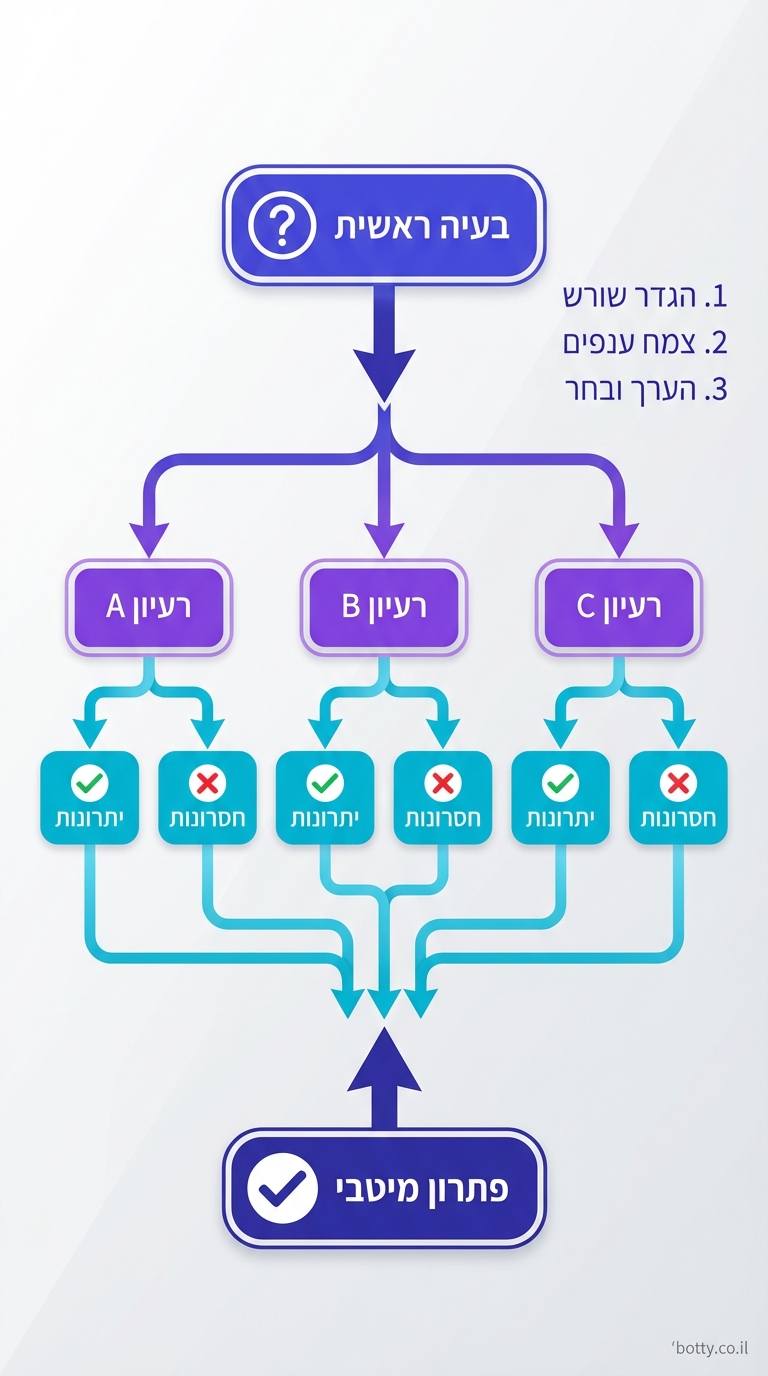

Verification Prompts

מבקשים מה-AI לבדוק את עצמו: "עכשיו בדוק את התשובה שנתת. האם יש שגיאות? האם חסר מידע? תקן אם צריך." מחקרים מראים שזה מצמצם hallucinations ב-20-30%.

Meta-Prompting

שימוש ב-AI כדי לכתוב פרומפטים טובים יותר. שואלים: "מהו הפרומפט הכי טוב שאפשר לכתוב כדי ש-LLM ייצור X?" — ואז משתמשים בתוצאה.

טעויות נפוצות

- פרומפט ארוך מדי — יותר טקסט לא אומר יותר טוב. הוראות ארוכות מדי גורמות ל-AI "לאבד" חלקים. היו קצרים וממוקדים

- הוראות סותרות — "תהיה יצירתי אבל דבק בעובדות" — ה-AI לא יודע מה עדיף. תעדיפו

- חוסר דוגמאות — אם אתם רוצים פורמט ספציפי, תראו דוגמה אחת לפחות

- התעלמות מ-temperature — temperature גבוה = יותר יצירתי, נמוך = יותר עקבי. בחרו לפי המשימה

כלים שעוזרים

לא חייבים לעבוד לבד:

- Anthropic Prompt Generator — כלי חינמי שעוזר לבנות System Prompts אפקטיביים

- promptingguide.ai — מדריך קהילתי מקיף עם טכניקות ומחקרים

- Claude Code /init — יוצר CLAUDE.md אוטומטי שהוא בעצם System Prompt לפרויקט שלכם

שילוב Prompt Engineering עם RAG (שליפה חכמה) מאפשר ליצור מערכות שנותנות תשובות מדויקות על בסיס מידע עדכני — ולא רק מה שהמודל "זוכר" מהאימון.

שאלות נפוצות

האם Prompt Engineering עדיין רלוונטי כשהמודלים משתפרים?

כן. מודלים טובים יותר = יכולים לעשות יותר = צריך לדעת לכוון אותם טוב יותר. זה כמו לשאול אם צילום עדיין רלוונטי כשהמצלמות השתפרו — ההפך, יש יותר אפשרויות.

מה ההבדל בין Prompt Engineering ל-Fine-Tuning?

Prompt Engineering משנה את ההוראות בלי לשנות את המודל. Fine-Tuning משנה את המודל עצמו על בסיס דאטה ספציפי. Prompt Engineering הוא מהיר, זול ופשוט. Fine-Tuning דורש דאטה, זמן וכסף — אבל נותן תוצאות עקביות יותר לתחומים מאוד ספציפיים.

איך מודדים אם פרומפט טוב?

על ידי הגדרת מדדים: דיוק, עקביות, התאמה לפורמט, ומהירות. הריצו את אותו פרומפט 10 פעמים — אם התוצאות עקביות ומדויקות, הפרומפט טוב. אם יש שונות גבוהה — צריך לשפר.